- Яндекс.Вебмастер.

Вебмастер Яндекса довольно неплохой инструмент веб-аналитики, плохо то, что многие не умеют им пользоваться, а зря. Для начала вытащим страницы в поиске яндекса:

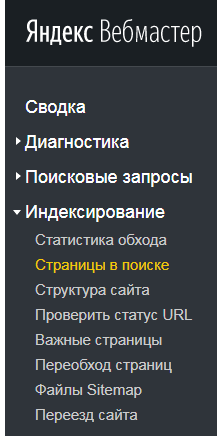

Заходим в Вебмастер – >Выбираем сайт –> Индексирование –> Страницы в поиске.

Нажимаем кнопку Последние изменения и скачиваем таблицу со страницами XLS (внизу справа).

Файл может содержать следующие данные:

- updateDate — дата обновления поисковой базы;

- url — адрес страницы;

- httpCode — HTTP-код, полученный роботом во время последнего обхода;

- status — статус страницы;

- target — адрес страницы, на которую происходит перенаправление, или отображаемый в результатах поиска адрес;

- lastAccess — дата последнего посещения страницы роботом;

- title — заголовок страницы (содержимое HTML-элемента title);

- event — действие, произошедшее со страницей (добавление или исключение из поиска).

Информация взята тут https://yandex.ru/support/webmaster/service/searchable.html

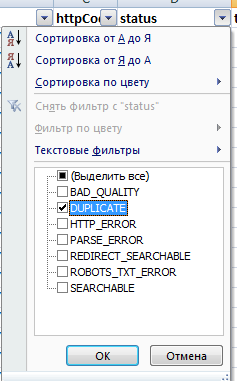

Открываем файл. Нас интересует статус DUPLICATE – дубль.

Далее включаем фильтр в Excel и выбираем страницы со статусом DUPLECATE. Как правило, если поисковик считает страницу дублем она удаляется из поиска (не всегда), и последний столбец принимает значение DELETE.

Дублями могут быть как обычные страницы, так и PDF документы. Довольно часто PDF документы закрывают от индексации, но если делать этого нельзя, нужно проверить мета данные документа и изменить заголовки PDF документов, сделать их (заголовки, а по возможности и сами документы) уникальными. Довольно часто можно встретить ситуацию, когда инструкция, например, к телефону в формате DPF считается более релевантной страницей. В данном случае карточка товара может не индексироваться вовсе, так как она будет считаться дублем. В данном случае для продвижения карточки товара необходим тщательный анализ, в том числе на пост фильтры. Исправить подобною ситуацию «в два клика» не получиться.

Итак, у нас есть список дублей страниц нашего сайта.

- Гугл вебмастер.

Гугл вебмастер показывает не дубли как таковые, а страницы с одинаковыми заголовками и мета описаниями, которые могут быть дублями с высокой вероятностью.

Заходим в Гугл Вебмастр –> Выбираем сайт –> Вид в поиске –> Оптимизация HTML

Тут есть проблема с выгрузкой данных. Данные можно выгрузить в гугл документы и CSV файл. В первом случае адреса страниц разделены знаком «|» и находятся в одной ячейке что, собственно, не очень удобно. Во втором случае в выгруженном файле не правильная кодировка, расшифровать файл можно с помощью декодера на сайте Артемия Лебедева https://www.artlebedev.ru/decoder/

3 Smart SEO Tool.

Программа Smart SEO Tool – подробней о программе можно прочитать (статью пока не написал) на сайте разработчика. Работать с программой очень просто, скачиваете, устанавливаете в два клика, вводите адрес сайта и нажимаете кнопку Начать анализ. Получаете неплохой отчет.

4 Ручками.

Вводим в гугле site:адрес вашего сайта, например site:abuzov.ru Ищем дубли и удаляем.

Ручной метод подойдет для небольших сайтов, до 100 страниц. Если ваш сайт довольно большой, рекомендую использовать первые три метода.